EU-Verordnung

AI Act: Regulierung von KI im Gesundheitswesen

Der europäische AI Act ist das weltweit erste Gesetz, das Künstliche Intelligenz (KI) umfassend regelt. In vielerlei Hinsicht ein Triumph, verunsichert die neue Gesetzgebung aber auch viele, vor allem im Gesundheitswesen. Denn KI-Medizinprodukte landen sehr schnell in der höchsten Risikoklasse – mit weitreichenden Folgen.

Die KI-Expertinnen Dr. Tanja Bratan, Leiterin Geschäftsfeld Innovationen im Gesundheitssystem beim Fraunhofer-Institut für System- und Innovationsforschung ISI, Dr. Andrea Sautter, Rechtsanwältin bei Taylor Wessing und Dr. Julia Hoxha, Leiterin der AG Health beim Bundesverband der Unternehmen der Künstlichen Intelligenz in Deutschland, erläutern die Anforderungen der Verordnung über Künstliche Intelligenz (AI Act), und was sie für das Gesundheitswesen bedeutet.

KI wird im Gesundheitswesen immer häufiger eingesetzt

Dr. Tanja Bratan ist Leiterin des Geschäftsfelds Innovationen im Gesundheitssystem am Fraunhofer-Institut für System- und Innovationsforschung ISI. © Daniel George

Dr. Tanja Bratan ist Leiterin des Geschäftsfelds Innovationen im Gesundheitssystem am Fraunhofer-Institut für System- und Innovationsforschung ISI. © Daniel GeorgeVon einem KI-Hype zu sprechen, ist derzeit wohl kaum übertrieben: Von Chatbots wie ChatGPT und Gemini über E-Commerce-Programme bis hin zu Bewerbungssoftware scheint ohne Künstliche Intelligenz in den kommenden Jahren kaum mehr etwas zu gehen. Besonders große Hoffnungen bestehen jedoch im Gesundheitswesen. Hier könnten durch Maschinelles Lernen Diagnosen genauer und Behandlungen effektiver sowie günstiger werden.

Nach Einschätzung der Forschungsplattform MarketsandMarkets wird der Markt für KI im Gesundheitswesen zwischen 2024 und 2029 um 48,1 Prozent wachsen.1) Doch neben dem enormen Potenzial dürfe man auch die Gefahren nicht unterschätzen, mahnt KI-Expertin Bratan vom Fraunhofer ISI: „Vor allem gibt es Bedenken beim Datenschutz. Aber auch falsche oder zweifelhafte Therapieempfehlungen, Diskriminierung oder mangelnde Transparenz der Entscheidungen sind ein mögliches Problem.“ Genau solchen Gefahren soll die europäische Verordnung zur Künstlichen Intelligenz (auch KI-Verordnung oder AI Act genannt) unter anderem vorbeugen.2)

Was regelt der AI Act? Ein Überblick

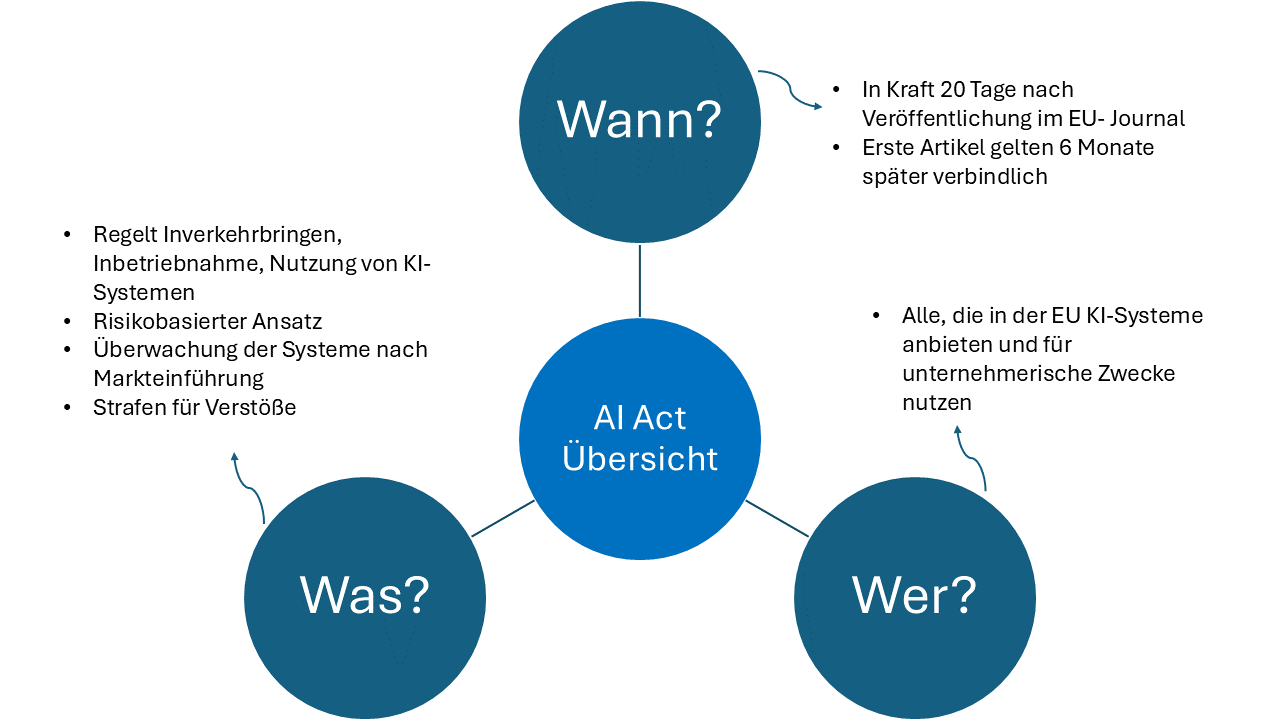

Aufgrund der weitreichenden Einsatzfelder von Künstlicher Intelligenz regelt die KI-Verordnung diese umfassend: vom Inverkehrbringen über die Inbetriebnahme bis hin zur Nutzung von KI-Systemen in der EU. Dabei verfolgt der AI Act einen risikobasierten Ansatz: Je höher das Risiko eines Systems, desto strenger die Anforderungen, die es erfüllen muss. Auch Regelungen zur Überwachung der Systeme nach Markteinführung legt der AI Act fest sowie die Pflicht, AI Literacy, also KI-Fachwissen in Unternehmen zu schaffen, die diese Systeme anbieten oder verwenden. Bei Verstößen drohen empfindliche Strafen von bis zu 35 Mio. Euro oder 7 Prozent des Jahresumsatzes. Die Verordnung gilt unmittelbar wie ein Gesetz in allen EU-Mitgliedstaaten und muss von diesen nicht erst national umgesetzt werden.

Eine grobe Übersicht darüber, was der AI Act regelt.

© Anja Segschneider

Eine grobe Übersicht darüber, was der AI Act regelt.

© Anja Segschneider

Was gilt als KI laut AI Act?

Die Definition von Künstlicher Intelligenz war einer der umstrittensten Punkte des AI Acts und hat sich im Laufe der Zeit geändert. Ein System muss folgende Kriterien erfüllen, um demnach als KI zu gelten:

- Es ist ein maschinengestütztes System,

- das für einen autonomen Betrieb ausgelegt ist,

- das nach dem Bereitstellen anpassungsfähig ist, und

- das eigene Schlüsse aus Eingaben zieht, beispielsweise für

- Vorhersagen

- Inhalte

- Empfehlungen

- Entscheidungen

- oder andere Ergebnisse.

- Die Ergebnisse dieser autonomen Operationen können physische oder virtuelle Umgebungen beeinflussen.

Diese recht komplexe Definition läuft letztlich auf einen zentralen Punkt hinaus: KI-Systeme arbeiten zu einem gewissen Grad autonom.

Risikobasierter Ansatz des AI Acts

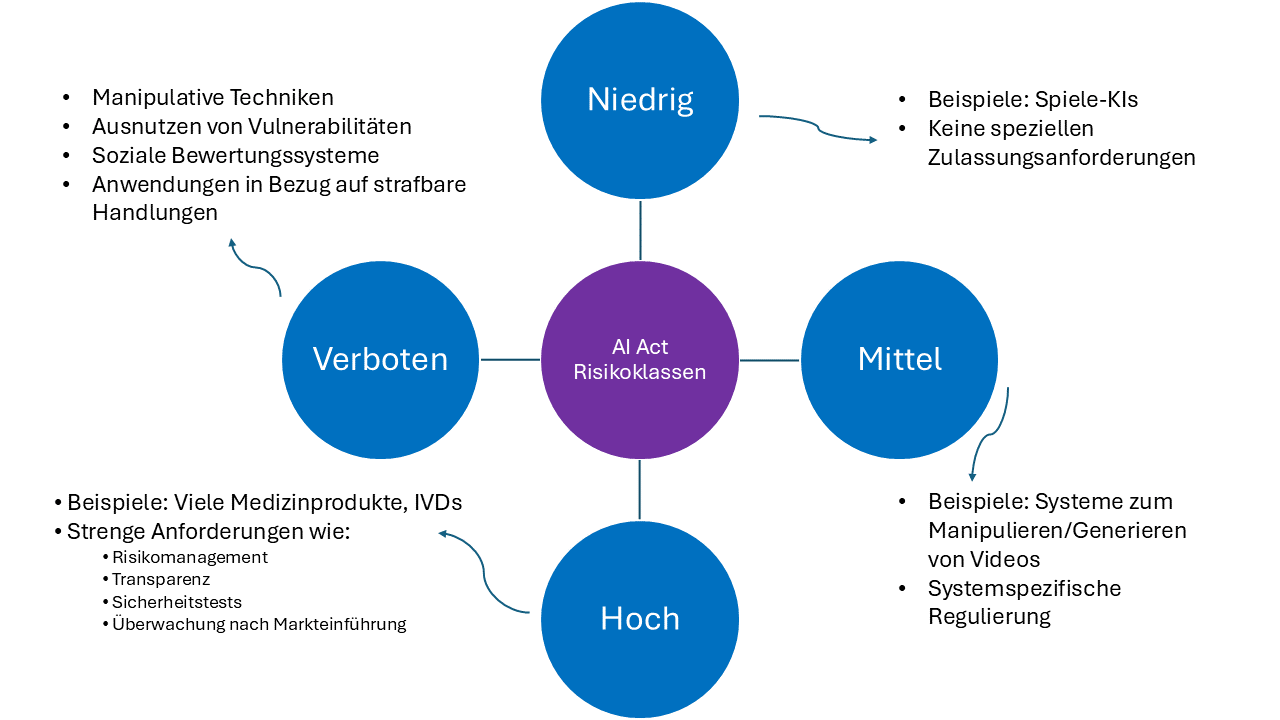

Die KI-Verordnung verfolgt einen risikobasierten Ansatz. Das bedeutet, dass die Anforderungen an die Systeme je nach Risiko, das von ihnen ausgeht, steigen.

Der AI Act verfolgt einen risikobasierten Ansatz: Mit steigendem Risiko steigen auch die Anforderungen an die KI-Systeme

© Anja Segschneider

Der AI Act verfolgt einen risikobasierten Ansatz: Mit steigendem Risiko steigen auch die Anforderungen an die KI-Systeme

© Anja Segschneider

Minimales Risiko und mittleres Risiko:

Als KI-Systeme mit minimalem Risiko stuft die Verordnung beispielsweise einfache Spiel-KIs ein. Solche Systeme unterliegen keinen besonderen Zulassungsanforderungen. Bestimmte Systeme mit mittlerem Risiko werden dagegen in der Verordnung explizit genannt und entsprechend ihrem Risiko reguliert. Dazu gehört insbesondere KI, die mit natürlichen Personen interagiert und zum Beispiel Emotionen erkennen oder Text-, Bild-, Audio- und Videoinhalte erstellen kann.

Verbotene KI-Systeme (Art. 5):

Bestimmte KI-Systeme sind nach Artikel 5 KI-Verordnung komplett verboten. Darunter fallen: manipulative Techniken, das Ausnutzen von Vulnerabilitäten wie Alter, Behinderung oder sozialer Lage, soziale Bewertungssysteme (Social Scoring) und viele Anwendungen in Bezug auf strafbare Handlungen.

Hochrisiko-KI-Systeme (Art. 6):

Hochrisiko-KI-Systeme müssen strenge Anforderungen erfüllen. Was als hohes Risiko im Sinne des AI Act gilt, bestimmt sich nach den Kriterien des Artikels 6. Ein KI-System gilt als Hochrisiko-System, wenn

- das KI-System selbst oder das Produkt, in dem das KI-System als Sicherheitskomponente eingesetzt wird, zu einer der in Anhang I aufgeführten Produktkategorien gehört (dazu gehören nach Nr. 11 und 12 auch Medizinprodukte und IVD)

- und das Produkt einer Konformitätsbewertung durch Dritte nach den aufgeführten Vorschriften zu unterziehen ist.

Dies bedeutet, dass die meisten Medizinprodukte und IVD der höheren Risikoklassen (Medizinprodukte ab Klasse IIa und IVD ab Klasse B), die KI einsetzen, als Hochrisikoprodukte im Sinne des AI Act eingestuft werden dürften. Medizinprodukte mit Softwarekomponenten fallen meist darunter.

Welche Anforderungen müssen Hochrisiko-Medizinprodukte erfüllen?

Fällt ein Medizinprodukt erst einmal in die Hochrisikoklasse, gelten im AI Act strenge Anforderungen. Einige davon sind Medizinprodukteherstellern allerdings schon bekannt:

- Risikomanagementsystem (Art. 9),

- Technische Dokumentation (Art. 11 und 18),

- Cybersicherheit (Art. 15),

- Qualitätsmanagementsystem (Art. 17),

- Konformitätsbewertung durch eine Benannte Stelle (Art. 16 und Kap. 5),

- Korrekturmaßnahmen und Berichtspflichten (Art. 20),

- Kooperation mit Behörden (Art. 21).

Hinzu kommen jedoch auch einige neue, KI-spezifische Anforderungen:

- Nutzen von hochwertigen Daten zum Trainieren und Validieren des KI-Systems (Art. 10) und Schutz der Trainingsdaten vor Manipulation (Art. 15),

- Aufzeichnungen und Protokolle über Vorgänge und Ereignisse (Art. 12),

- Hohe Ansprüche an Transparenz (Art. 13 und 16),

- Menschliche Aufsicht über das System (Art. 14),

- Besondere Pflichten für Importeure, Nutzer, Händler und entlang der Wertschöpfungskette (Art. 22 ff.),

- Grundrechtliche Folgenabschätzung für bestimmte Einsatzgebiete (Art. 27).

Ab wann gilt der AI Act?

Der AI Act tritt 20 Tage nach seiner Veröffentlichung im Journal der Europäischen Union in Kraft, also am 01.08.2024. Sechs Monate später (01.02.2025) sind die ersten Bestimmungen der Kapitel I und II (allgemeine Bestimmungen und verbotene Praktiken) verbindlich. Kapitel III Abschnitt 4, Kapitel V, VII, XII und Artikel 78 gelten nach zwölf Monaten, also ab 01.08.2025 (Ausnahme: Artikel 101). Die Regelungen zu Hochrisikosystemen in Artikel 6 Absatz 1 und die damit zusammenhängenden Bestimmungen gelten nach 36 Monaten (01.08.2027). Alle übrigen Vorschriften gelten 24 Monate nach Inkrafttreten der Verordnung (01.08.2026).

Für die KI-Systeme, die in der Zwischenzeit bereits auf den Markt gekommen sind, gelten Übergangsfristen.

Was kommt also mit dem AI Act auf die Gesundheitsbranche zu?

Dr. Julia Hoxha ist Leiterin der AG Health beim KI Bundesverband sowie CEO und Gründerin der Zana GmbH. © Julia Hoxha

Dr. Julia Hoxha ist Leiterin der AG Health beim KI Bundesverband sowie CEO und Gründerin der Zana GmbH. © Julia Hoxha„Aus unserer Branchenperspektive sind wir der Ansicht, dass dieses Gesetz weitreichende Auswirkungen für alle Beteiligten hat, nicht nur für die KI-Anbieter“, erklärt Expertin Hoxha. „Auch Krankenhäuser und andere Anwender sind betroffen. Und gerade KMUs haben große Bedenken, dass nun noch höhere Kosten auf sie zukommen. Allerdings müssen sich diese Befürchtungen nicht unbedingt bewahrheiten.“ Denn beispielsweise könnten Hersteller in vielen Fällen durch gute Planung und kluges Design verhindern, dass ihr KI-System in eine unnötig hohe Risikoklasse fällt. Zudem sieht der AI Act zahlreiche Ausnahmen und Erleichterungen für kleinere Unternehmen und die Forschung vor. In den vorgesehenen „Sandboxes“ können sich gerade junge innovative Firmen einbringen und die Branche in Zukunft mitgestalten.

Rechtsanwältin Sautter rät Unternehmen, zu prüfen, ob es sich für einzelne Produkte lohnt, sie bereits jetzt auf den Markt zu bringen, um später von den Übergangsregeln profitieren zu können. „Und dann muss man natürlich möglichst bald für den Aufbau des rechtskonformen Systems die Ressourcen schaffen und das Team möglichst zeitnah schulen“, sagt sie.

Doch trotz aller Bedenken sind sich die Expertinnen am Ende überraschend einig, dass die KI-Verordnung mehr Chancen als Risiken bietet: „Ich denke, wir sind damit weltweit absolute Vorreiter“, meint Bratan. „Wir haben außerdem die enorme Chance, uns in Europa durch sichere und qualitativ hochwertige KI-Systeme von Anfang an auszuzeichnen – und uns damit vielleicht sogar einen Marktvorteil zu verschaffen.“